TEKOÄLYN HALLINTAMALLIT

Maailmalla on todettu, että tekoälyä ohjelmistoprojekteina tai analyyttisinä algoritmeina kehittävät toimijat epäonnistuvat tavoitteidensa saavuttamisessa. Tekoälyratkaisuja käyttöönottavien organisaatioiden tulee onnistua sekä toiminnan muutoksessa, tiedon käsittelyssä, ohjelmistoprojekteissa että algoritmien kehittämissä. Tämän vuoksi tekoälyn kehittämistä ja käyttöönottoa tulee ohjata järjestelmällisesti tasapainoillen erilaisten eettisten näkökulmien kesken sekä rakentaen vastuullisuutta osaksi liiketoimintaa aina tekoälyratkaisun ideasta kyseisen toiminnan alasajoon asti.

Tekoälyn vaikutukset mietityttävät yrityksiä

Tekoäly on noussut viimevuosina yhdeksi merkittävimmistä keskustelunaiheiksi eri alojen ammattilaisten, tutkijoiden ja kansalaisten keskuudessa. Keskusteluissa huomiota ovat herättäneet niin tekoälyratkaisujen näyttävät epäonnistumiset kuin toisaalta uraauurtavat saavutuksetkin. Ihmiset tunnistavatkin tekoälyn mahdollisuudet arkielämän ja liiketoiminnan osa-alueiden mullistajana yhä laajemmin, mutta samanaikaisesti he ovat havahtuneet tekoälyn mahdollisiin ongelmiin ja haittavaikutuksiin. Tämän vuoksi monet organisaatiot sekä julkishallinnossa että yksityisellä sektorilla epäröivät tekoälyratkaisujen hankkimisessa ja kehittämisessä.

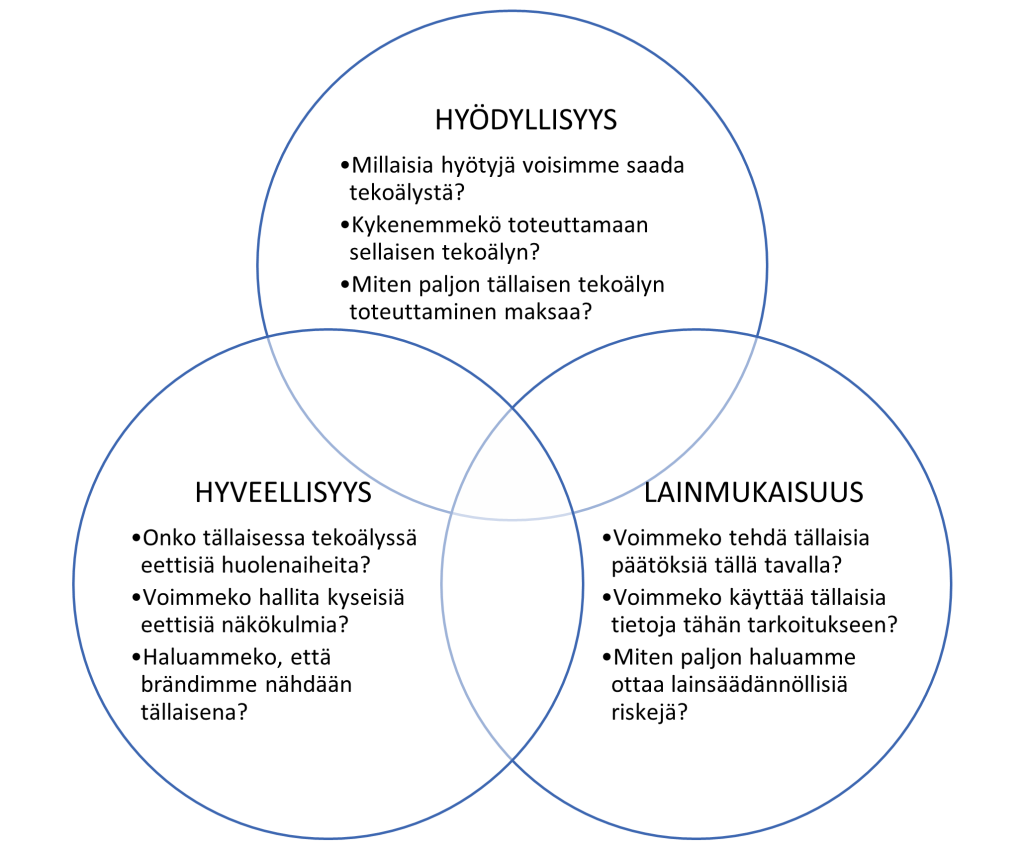

Siili Solutions Oyj:n asiakkaiden kanssa keskustellessamme olemme havainneet kolme teemaa, jotka mietityttävät heitä – ratkaisujen hyödyllisyys, lainmukaisuus ja hyveellisyys (kuva 1).

Kuva 1: Onnistuneet tekoälyratkaisut ovat sekä hyödyllisiä, lainmukaisia että hyveellisiä.

Kuva 1: Onnistuneet tekoälyratkaisut ovat sekä hyödyllisiä, lainmukaisia että hyveellisiä.

Puutteet ja epäilykset yhdessäkin edellä mainituissa aihepiireissä voivat estää projektien etenemisen ja johtaa kalliiseen epäonnistumisiin. Edellä mainittujen huolien vuoksi monet yritykset eivät edes aloita tekoälyprojekteja. Tällaiseen varovaisuuteen on myös hyviä syitä.

Tekoälyratkaisujen käyttöönotto on monimutkaista

Ruokalähettipalveluja tuottava Deliveroo pisteytti lähettejään algoritmilla priorisoidakseen tilauksia sopivimmille läheteille. Italialainen tuomioistuin kuitenkin tuomitsi yrityksen sakkoihin todeten algoritmin olevan työlainsäädännön vastainen. Tuomioistuin esitti, että algoritmi saattoi antaa heikommat pisteet lähetille jonka aktiivisuustaso heikkeni lomien, sairaspoissaolojen, lakkojen tai vastaavien toimintakatkojen aikana. Deliveroo ei kyennyt todentamaan, että algoritmi ei syrji lähettejä tällaisten lakisääteisesti turvattujen taukojen vuoksi sekä vetosi siihen että se kohtelee kaikkia samalla tavalla. Algoritmi poistettiin kuitenkin käytöstä. Kiinteistömarkkinoija Zillow puolestaan yritti ennustaa tekoälyn avulla kiinteistöjen kehittämispotentiaalia. Tästä seurasi miljardiluokan tappiot kiinteistöjen arvon osoittautuessa ennusteita heikommaksi, sillä niiden jälleenmyynti ei onnistunutkaan odotetusti. Myös Zillow lopetti algoritmin käytön sekä koko kiinteistöjen hankinta- ja jälleenmyyntiliiketoimintansa. Maailmalta raportoidaan jatkuvasti esimerkkejä siitä miten tekoälyn algoritmiset päättelymekanismit voivat epäonnistua hyvinkin ikävin seurauksin.

Monet yritykset, kuten esimerkiksi kaikkien tuntema Google, seuraavat suurta osaa maailman ihmisistä erilaisten valvontamekanismien avulla. Suuri osa tällaisesta henkilöön kohdennetusta massavalvonnasta on todettu jo kauan sitten Euroopan tietosuojalainsäädännön vastaiseksi. Esimerkiksi Ranskan tietosuojaviranomainen antoi vuonna 2020 Googlelle 120 miljoonan euron sakon henkilötietojen keräämisestä ilman pätevää tiedonkäsittelyn kohteen suostumusta ja informointia. Toisaalta vertaisarvioiduissa tieteellisissä julkaisuissa on todettu Epic-potilaskertomusjärjestelmän tekoälyratkaisujen aiheuttaneen merkittävästi turhaa lisätyötä väärien hälytyksien vuoksi sekä olleen tarkkuudeltaan muutenkin erittäin heikkoja. Kaikki tekoälyratkaisut eivät välttämättä osoittaudu kaikissa ympäristöissä ja käytännössä yhtä tehokkaiksi kuin ne ovat voineet olla aiemmin rajatuissa ihanneolosuhteissa. Tekoälyn käyttöönottoa harkitsevia organisaatioita mietityttääkin tämän vuoksi sekä tekoälyn tarvitseman tiedon käsittelyn lainmukaisuus että käytettävissä olevan tiedon laatu, joka saattaa osoittautua liian heikoksi tavoiteltujen hyötyjen saavuttamiseksi.

Sekä Suomen että Tanskan pääkaupunkiseutujen terveydenhuollon toimijat ovat olleet pitkään vaikeuksissa Epic-potilaskertomusjärjestelmänsä kanssa. Kehittämisen kustannukset ovat osoittautuneet ennakoitua suuremmiksi, odotettuja hyötyjä ei ole saatu useiden vuosien jälkeenkään ja tyytymättömät käyttäjät vaativat järjestelmästä luopumista. Helsingin kaupunki puolestaan pyrki uudistaamaan palkanlaskentaansa siirtymällä uuden palveluntarjoajan ja heidän ohjelmistonsa käyttäjiksi. Käyttöönoton jälkeen paljastui odottaman paljon virheitä, joiden vuoksi työntekijät saivat vääriä palkkoja ja saattoivat jäädä jopa kokonaan ilman palkkaa. Lehdistössä raportoitiin palkatta jääneiden työntekijöiden turvautuneen jopa korkeakorkoisiin pikavippeihin ja omaisuuden myyntiin päivittäisten kulujen kattamiseksi. Tällaiset monimutkaiset ohjelmistoprojektit voivat epäonnistua monilla eri tavoilla, joten on luonnollista että liiketoimintaa merkittävästi uudistavien tekoälyratkaisujen käyttöönottoon suhtaudutaan varovaisesti.

Yhdysvaltalainen Clearview AI taas kerää julkisesta verkosta valokuvia, joiden avulla se tuottaa algoritmisia kasvontunnistamispalveluja eri maiden viranomaisille ympäri maailmaa. Useat tietosuojaviranomaiset (esimerkiksi Ranska, Italia, Kreikka ja Iso-Britannia) ovat todenneet yrityksen tiedonkäsittelyn olevan monin tavoin tietosuojalainsäädännön vastaista, asettaneet kymmenien miljoonien eurojen sakkoja ja määränneet kerätyt tiedot poistettavaksi. Yhdysvaltojen puolustushallinnon tavoitteena oli puolestaan kehittää Googlen tuella ihmisten ja esineiden tunnistamismenetelmiä drone-lennokkien keräämien kuvien analysoimiseksi. Google päätti lopettaa tämän kiistanalaisen yhteistyön työntekijöiden vastareaktion jälkeen. Tällä tavalla koko tekoälyn suunniteltu liiketoiminnallinen käyttötarkoitus voi osoittautua lain- tai yhteisöjen mielipiteiden vastaiseksi.

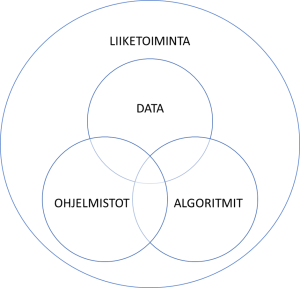

Ongelmat millä tahansa aiemmin mainituista ja kuvassa esitetyissä aihepiireistä voivat johtaa tekoälyratkaisun epäonnistumiseen (kuva 2).

Kuva 2: Tekoälyä käyttöönottavien organisaatioiden tulee onnistua sekä toiminnan muutoksessa, tiedon käsittelyssä, ohjelmistoprojekteissa että algoritmien kehittämissä.

Tekoälyn käyttöönottoa tulee ohjata järjestelmällisesti

Siili on työskennellyt jo jonkin aikaa algoritmisten päätöksenteon tukijärjestelmien ja tekoälyratkaisujen parissa sekä arkaluonteisissa että kriittisissä yhteyksissä. Tekoälyn käsitteleminen pelkästään ohjelmistoprojektina ei meidänkään kokemuksien mukaan ole johtanut menestykseen sen enempää asiakkaan kuin toimittajankaan näkökulmasta. Myös maailmalta tulevat esimerkit korostavat kokonaisvaltaisemman liiketoiminnan kehittämisen näkökulman merkitystä. Tällaisten huomioiden vuoksi tunnistimme tarpeen kehittää uusia menetelmiä, jotka auttaisivat tekoälyratkaisujen kehittämisessä ja ohjaamisessa kokonaisvaltaisemmin sekä eettisten näkökulmien järjestelmällisemmässä huomioimisessa.

Edellä mainituista syistä päädyimme liittymään Turun yliopiston koordinoimaan AI Governance and Auditing (AIGA) -tutkimusohjelmaan. AIGA-ohjelman tavoitteena on kehittää osaamista ja menetelmiä siihen miten tunnistetaan, suunnitellaan, toteutetaan ja käytetään selitettävissä olevia tekoälyratkaisuja, jotka ovat eettisesti ja oikeudellisesti hyväksyttäviä sekä johtavat kestävään liiketoiminta-arvoon.

Projektin aikana tunnistimme Siilissä kaksi merkittävää teemaa, jotka tulisi huomioida perinteisen ohjelmisto- ja algoritmikeskeisen projektitoimituksen lisäksi: liiketoiminnan muutoksen elinkaari ja eettiset näkökulmat.

Tekoälyn kehittämistä tulisi ohjata huomioiden koko liiketoiminnan muutoksen elinkaari tekoälyn liikeideasta lopulliseen käytöstä poistamiseen asti. Tekoälyratkaisuja ohjelmistoprojekteina kuvaavat koneoppimisjärjestelmien elinkaarimallit ovat täten näkökulmaltaan aivan liian suppeita ja kapeita. Organisaation toiminnan kehittäminen ohjelmistoprojekteina ei ole toiminut ohjelmistotuotannon puolellakaan eikä se tule toimimaan tekoälynkään osalta. Tämä sen vuoksi, että ohjelmistoratkaisun toteuttamiseen tähtäävät projektit rajaavat vastuunsa ja näkökulmansa tekniseen toteutukseen. Ne eivät huomioi riittävästi liiketoiminnalle merkittäviä näkökulmia kuten aidosti erilaisia vaihtoehtoisia ratkaisumalleja, organisaation muutosjohtamista tai käyttäjämassojen koulutuksia.

Tekoälyä käyttöönotettaessa erityisen tärkeää on aloittaa liiketoiminnan tavoitteiden ja käyttötapausten suunnittelusta. Tämä sen vuoksi, että usein et voi korjata asiaa, jota ei olisi pitänyt rakentaa alunperinkään. Usein vähemmälle huomiolle jätetään myös tekoälyratkaisujen elinkaaren loppuosa eli toiminnan alasajo. Käytännössä organisaatioiden tulisi suunnitella myös miten ohjelmisto, käsitellyt tiedot tai tekoäly voidaan poistaa käytöstä ja valmistautua seurauksiin jotka syntyvät liiketoiminnalle näistä toimenpiteistä. Aiemmin mainituissa esimerkkitapauksissa muunmuassa Deliveroo ja Zillow joutuivat luopumaan algoritmiensa käytöstä ja Zillow jopa koko liiketoiminta-alueestaan.

Tekoälyn kehittämistä ohjattaessa on tärkeää myös tasapainottaa erilaiset eettiset näkökulmat: hyöty-, velvollisuus- ja hyve-etiikka. Haasteelliseksi tämän tekee se että eettisiin valintoihin ei ole aina löydettävissä yhtä tai edes oikeaa ratkaisua. Käyttöönottavan organisaation tulee tehdä valintoja ristiriitaisten vaatimusten, epämääräisten epävarmuuksien ja muuttuvien painotusten kesken. Tällaisten erilaisten näkökulmien huomiominen vaatii sekä monialaista että yksityiskohtaista osaamista monilta eri asiantuntija-aloilta.

Usein ei riitä yksittäisten alojen asiantuntijoiden tuominen yhteen, sillä he eivät kykene tunnistamaan eri alojen yksityiskohtien piileviä yhteyksiä. Lakiasiantuntijat eivät ymmärrä mitä teknologisten laitteiden sisällä oikeasti tapahtuu ja data-ammattilaiset eivät ymmärrä lakitekstien yksityiskohtien merkitystä omassa tekemisessään. Monialaisten ongelmien tunnistamiseen ja ratkaisemiseen tarvitaankin useiden eri alojen asiantuntemusta yhdisteleviä moniosaajia, jotka ovat toimineet pitkään tällaisissa haasteellisissa ympäristöissä. Tämä sen vuoksi, että vain he kykenevät tunnistamaan yksittäisten alojen yksityiskohtien merkitykset toisien alojen toisiin yksityiskohtiin.

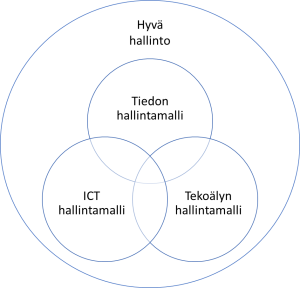

Tekoälyn kehittäminen ja käyttöönotto on usein niin merkittävä toiminnanmuutos, että sen ohjaamiseksi tarvitaan tekoälyn hallintamallia (AI Governance). Tällaista uutta vastuiden ja velvollisuuksien organisointimallia ei voi kuitenkaan tuoda ulkopuolelta osaksi organisaation toimintaa tai rakentaa rinnakkaiseksi todellisuudeksi organisaation muun toiminnan ulkopuolelle. Tällaiset byrokratia-yritelmät päätyvät usein hienoiksi dokumenteiksi ja turhiksi hallintopalavereiksi, joita ei kuitenkaan noudateta arkipäivän toiminnassa tai käytännön kehittämisprojekteissa. Maailmalla on todettu usein, että aihepiirikohtaiset hallintamallit tulee sulauttaa tapauskohtaisesti osaksi organisaation kulttuuria ja vallitsevaa hyvää hallintoa (Corporate governance). Tällä tavalla niin tiedon käsittelyn (Data Governance), ICT-palvelujen (ICT Governance) kuin tekoälynkin hallintamallit (AI Governance) sulautetaan täydentämään vallitsevia organisaation rakenteita ja päätöksenteon mekanismeja.

Kuva 3: Organisaatioiden tulee sulauttaa hyvään hallintoonsa tiedon käsittelyn, tietotekniikan ja tekoälyn ohjausmenetelmät.

Kuva 3: Organisaatioiden tulee sulauttaa hyvään hallintoonsa tiedon käsittelyn, tietotekniikan ja tekoälyn ohjausmenetelmät.

Tekoälyä voi käyttää myös onnistuneesti

Esimerkiksi Deliveroon kilpailija Wolt on panostanut toiminnan läpinäkyvyyteen ja lähettien yhdenvertaisuuteen heidän kilpailuttamisensa sijaan. Samoihin aikoihin kun kilpailija Deliveroo joutui ongelmiin läpinäkymättömän ja syrjivän pisteytysalgoritminsa vuoksi niin Wolt päätti kehittää ja julkaisi raportin algoritmisesta läpinäkyvyydestään ja eettisistä näkökulmistaan. Tällä tavalla yritykset voivat tehdä tietoisia valintoja resurssiensa kilpailuttamisen ja heidän voimaannuttamisensa välillä tai läpinäkymättömän tehokkuuden tavoittelun ja läpinäkyvyyttä korostavan kulttuurin välillä. Tekoälyn käyttöönotto vaatiikin organisaatioita usein tekemään tällaisia liiketoimintamallinsa strategisia peruslinjauksia erilaisista eettisistä näkökulmista.

Suuri osa maailman organisaatioista käyttää erilaisia tekoälyyn perustuvia markkinointiautomaatiojärjestelmiä vakoillakseen kansalaisia Euroopan tietosuojalainsäädännön vastaisesti ja käyttääkseen kyseisiä tietoja kohdennettuun markkinointiin. Eettinen toimija voi kyseenalaistaa tällaisen vallitsevankin toimintamallin ja päätyä täysin toisenlaiseen ratkaisuun. Pedigree päätti henkilötietojen keräämisen sijaan pyrkiä havainnoimaan koiria mainostauluihin upotettujen kameroidan kautta kohdentaakseen mainoksia koirien ominaisuuksien perusteella. Täsmämainokset tavoittivat kauppakeskuksissa tietysti myös koirien kanssa liikkuvat omistajat – eettisesti, halvemmalla ja tuottoisammin. Pedigreen mainoskampanja oli valtava menestys laskien kustannuksia 34,4 % katsottua mainosta kohden ja tuottaen alueellisesti 29% kasvun myyntiin. Mainostaja ei tarvinnutkaan tietoa henkilön historiasta, ihmissuhteista, käyttäytymisestä tai muista ominaisuuksista. Heille riitti että tekoäly kohdensi oikean toimivan viestin sopivaan tilanteeseen riippumatta ketkä sen sattuisivat näkemään.

Ylläkuvatun kaltaisesti tekoälyä voi hyödyntää myös onnistuneesti eli hyödyllisesti, lainmukaisesti ja hyveellisesti. Tämä kuitenkin edellyttää sitä että ratkaisuja käyttöönottavien organisaatioiden tulee onnistua sekä toiminnan muutoksessa, tiedon käsittelyssä, ohjelmistoprojekteissa että algoritmien kehittämissä. Tässä onnistuminen taas edellyttää järjestelmällistä tekoälyn hallintamallia, joka sulauttaa eri asiantuntijoiden näkökulmat yhteen sekä ohjaa organisaatiota tekemään tietoisia valintoja huomioiden riittävän laajasti erilaisia eettisiä näkökulmia. Ennenkaikkea hallintamallin tulee rakentaa vastuullisuus osaksi liiketoimintaa tekoälyratkaisun ideasta aina toiminnan alasajoon asti.

Sami Laine

Varapuheenjohtaja, DAMA Finland ry

Competence Lead, Siili Solutions Oyj

Sami Laine on toiminut lähes 20 vuoden ajan tiedonhallinnan kehittäjänä, konsulttina, kouluttajana ja tutkijana useilla eri toimialoilla. Siili Solutions Oyj:ssä hänen erikoisalaansa on liiketoimintalähtöinen tiedon laadunhallinta strategioista käytännön toteutuksiin asti. DAMA Finland ry:n hallituksen varapuheenjohtajana hän edistää tiedon johtamisen hyvien käytäntöjen tunnettavuutta ja leviämistä osana kansainvälistä DAMA International-yhteisöä.

Sami Laine on toiminut lähes 20 vuoden ajan tiedonhallinnan kehittäjänä, konsulttina, kouluttajana ja tutkijana useilla eri toimialoilla. Siili Solutions Oyj:ssä hänen erikoisalaansa on liiketoimintalähtöinen tiedon laadunhallinta strategioista käytännön toteutuksiin asti. DAMA Finland ry:n hallituksen varapuheenjohtajana hän edistää tiedon johtamisen hyvien käytäntöjen tunnettavuutta ja leviämistä osana kansainvälistä DAMA International-yhteisöä.

Artikkeli perustuu Tivian Sytyke-yhdistyksen 9.9.2022 järjestämään Green ICT – huippuseminaarin esitykseen (linkki). Artikkeli on julkaistu ensimmäisenä Sytyke-lehdessä 4/2022 Huippuseminaarin 2022 satoa.